Trí tò mò vô tận của con người là điều tôi học được sau 15 năm làm việc liên quan tới Google Tìm kiếm (Google Search).

Có hàng tỷ lượt tìm kiếm mỗi ngày và 15% trong số đó chúng tôi chưa từng thấy trước đây – vì vậy chúng tôi đã xây dựng các cách trả kết quả tìm kiếm mà chúng tôi không thể dự đoán.

Xem thêm bài viết 15+ công cụ nghiên cứu từ khóa.

Khi sử dụng Tìm kiếm, chúng ta không chắc chắn về cách đặt câu hỏi đúng nhất. Chúng ta có thể không biết dùng đúng từ hoặc cách viết đúng chính tả, vì chúng ta thường sử dụng Tìm kiếm để tìm hiểu – chúng ta không nhất thiết phải biết về điều đó.

Quan trọng, Tìm kiếm là hiểu ngôn ngữ. Công việc của chúng tôi là hiểu bạn đang tìm kiếm gì và trả thông tin hữu ích từ trang web, dù bạn viết hoặc kết hợp các từ ra sao trong tìm kiếm.

Mặc dù trong nhiều năm qua chúng tôi liên tục cải thiện khả năng hiểu ngôn ngữ, đôi khi chúng tôi vẫn không hiểu đúng hoàn toàn, đặc biệt với các tìm kiếm phức tạp hoặc hội thoại.

Đó là lý do tại sao mọi người thường sử dụng “từ khóa bất kỳ” (“keyword-else”, gõ các từ họ nghĩ chúng tôi sẽ hiểu, nhưng thực ra không phải cách họ vốn đặt câu hỏi.

Với những cải tiến mới nhất từ nhóm nghiên cứu của chúng tôi về hiểu ngôn ngữ – có thể thực hiện nhờ học máy (machine learning) – chúng tôi đang cải tiến đáng kể cách hiểu các tìm kiếm, bước tiến lớn nhất trong 5 năm qua và một trong những bước nhảy vọt lớn nhất trong lịch sử Tìm kiếm.

Contents

Áp dụng mô hình BERT vào Tìm kiếm

Năm ngoái, chúng tôi đã công bố và cung cấp Đại diện bộ mã hóa hai chiều từ Transformers (Bidirectional Encoder Representations from Transformers), gọi tắt là BERT, kỹ thuật dựa trên mạng nơ-ron đối với mô hình học sẵn (pre-training) xử lý ngôn ngữ tự nhiên (natural language processing – NLP).

Công nghệ này cho phép bất cứ ai cũng có thể huấn luyện hệ thống trả lời câu hỏi tiên tiến của riêng họ.

Bước đột phá này là kết quả nghiên cứu của Google về transformers: các mô hình xử lý từ liên quan đến tất cả các từ khác trong một câu, thay vì từng từ một. Do đó, mô hình BERT có thể xem xét toàn bộ ngữ cảnh của một từ bằng cách xem xét các từ xuất hiện trước và sau – điều này đặc biệt hữu ích trong việc hiểu mục đích tìm kiếm.

Tuy nhiên, để có thể làm được điều này không chỉ là những tiến bộ trong phần mềm: chúng tôi cũng cần phần cứng mới.

Một số mô hình chúng tôi có thể xây dựng bằng BERT phức tạp đến mức chúng giới hạn những gì chúng tôi có thể làm khi dùng phần cứng truyền thống.

Do đó, chúng tôi lần đầu tiên sử dụng Cloud TPU mới nhất để phục vụ kết quả tìm kiếm và nhanh chóng cung cấp cho bạn thông tin liên quan.

Giải mã tìm kiếm của bạn

Có rất nhiều chi tiết kỹ thuật, nhưng nó có ý nghĩa gì với bạn? Bằng cách áp dụng các mô hình BERT cho cả đoạn trích nổi bật và xếp hạng trong Tìm kiếm, chúng tôi có thể giúp bạn tìm thông tin hữu ích tốt hơn.

Trên thực tế, khi nói đến kết quả xếp hạng, BERT sẽ giúp Tìm kiếm hiểu rõ hơn một trong 10 tìm kiếm ở Hoa Kỳ bằng tiếng Anh và dần dần chúng tôi sẽ áp dụng ở nhiều ngôn ngữ và quốc gia hơn.

Đặc biệt đối với các tìm kiếm hội thoại dài hơn hoặc các tìm kiếm trong đó các giới từ như “for” và “to” đóng vai trò quan trọng trong ý nghĩa, Tìm kiếm sẽ có thể hiểu ngữ cảnh các từ trong tìm kiếm của bạn. Bạn có thể tìm kiếm theo cách tự nhiên.

Để giới thiệu những cải tiến này, chúng tôi đã thực hiện rất nhiều thử nghiệm nhằm đảm bảo những thay đổi hữu ích hơn. Dưới đây là một số ví dụ cho thấy quá trình đánh giá của chúng tôi chứng minh khả năng BERT hiểu được mục đích tìm kiếm của bạn.

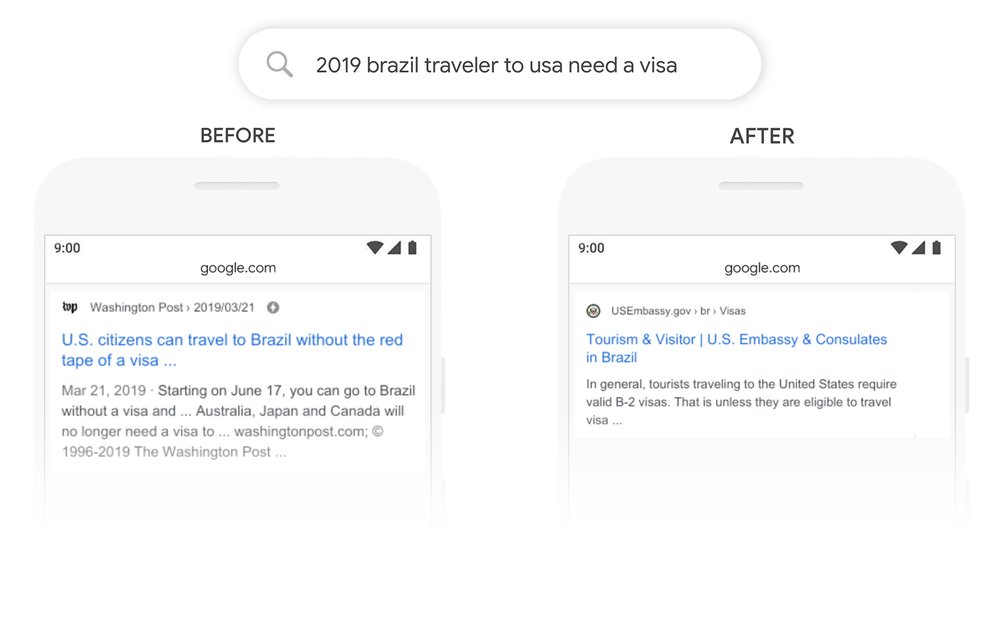

Đây là tìm kiếm “2019 brazil traveler to usa need a visa”. Từ “to” và mối quan hệ với các từ khác trong tìm kiếm đặc biệt quan trọng để hiểu ý nghĩa. Tìm kiếm về người Brazil đi du lịch đến Hoa Kỳ, không phải ngược lại.

Trước đây, thuật toán của chúng tôi sẽ không hiểu tầm quan trọng của mối quan hệ này và chúng tôi trả các kết quả về công dân Hoa Kỳ đi du lịch đến Brazil.

Với mô hình BERT, Tìm kiếm có thể hiểu được sắc thái này và biết từ rất phổ biến “to” thực sự quan trọng ở đây và chúng tôi có thể đưa ra kết quả phù hợp hơn cho tìm kiếm này.

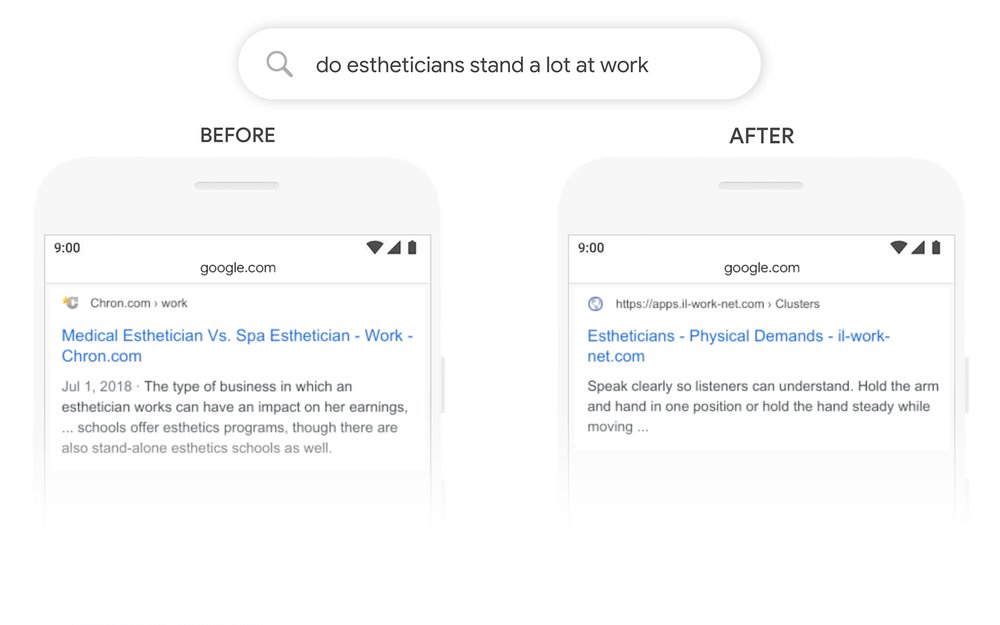

Cùng xem một tìm kiếm khác: “do estheticians stand a lot at work”. Trước đây, hệ thống của chúng tôi sử dụng phương pháp ghép các từ khóa phù hợp, thuật ngữ “stand-alone” trong kết quả với từ “stand” trong tìm kiếm.

Nhưng đó không phải là cách sử dụng đúng từ “stand” trong bối cảnh. Mặt khác, mô hình BERT hiểu rằng, “stand” liên quan đến khái niệm yêu cầu về thể chất của công việc và hiển thị câu trả lời hữu ích hơn.

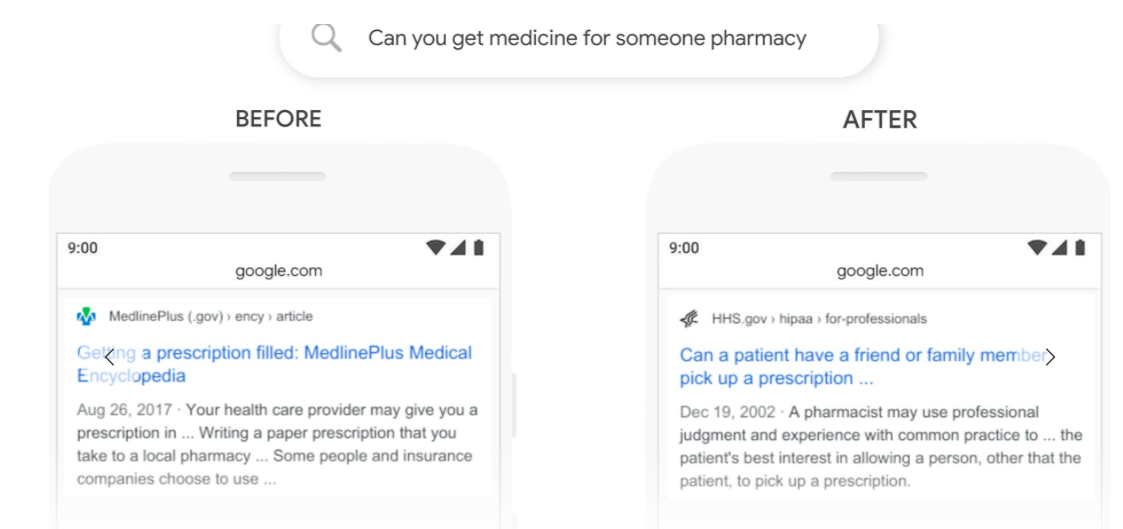

Dưới đây là một số ví dụ khác trong đó mô hình BERT giúp chúng tôi hiểu các sắc thái không dễ mô tả của ngôn ngữ mà máy tính chưa hiểu rõ như con người.

Với mô hình BERT, chúng tôi có thể hiểu rõ hơn rằng, “for someone” là phần quan trọng của tìm kiếm, trong khi trước đó chúng tôi bỏ qua ý nghĩa, với các kết quả chung về việc kê đơn thuốc.

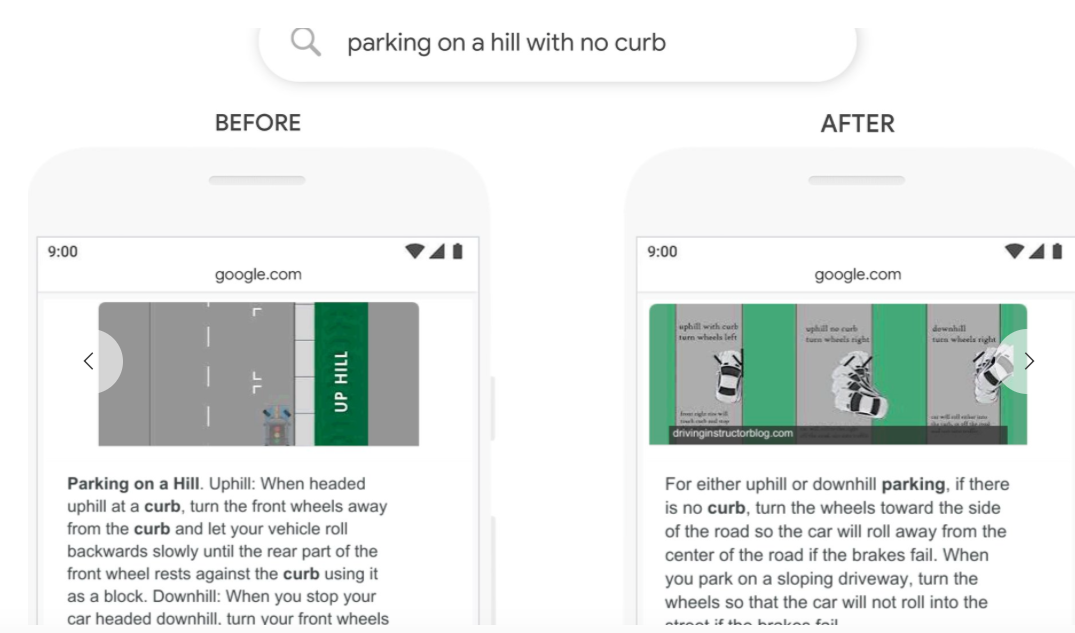

Trước đây, tìm kiếm kiểu này sẽ gây nhầm lẫn cho hệ thống của chúng tôi – chúng tôi chú ý quá nhiều đến từ “curb” và bỏ qua từ “no”, không hiểu từ đó quan trọng như thế nào để đưa ra tìm kiếm phù hợp. Vì vậy, chúng tôi trả các kết quả cho tìm kiếm “parking on a hill with a curb”!

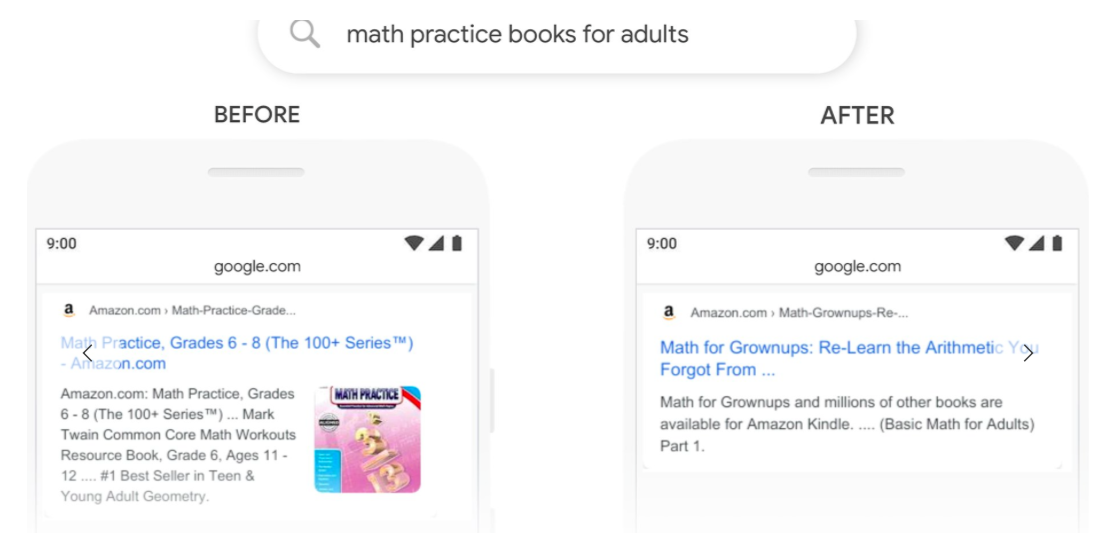

Mặc dù trang kết quả trước đó bao gồm một cuốn sách trong danh mục “Dành cho người lớn”, BERT có thể hiểu rõ hơn rằng “adult” đang được kết hợp không tách ra khỏi bối cảnh và chọn kết quả hữu ích hơn.

Cải thiện Tìm kiếm bằng nhiều ngôn ngữ hơn

Chúng tôi cũng đang áp dụng mô hình BERT để giúp mọi người Tìm kiếm tốt hơn. Một đặc điểm rất có tác động của các hệ thống này là chúng có thể học hỏi từ một ngôn ngữ và ứng dụng cho các ngôn ngữ khác. Vì vậy, chúng tôi có thể lấy các mô hình học hỏi từ các cải tiến bằng tiếng Anh (ngôn ngữ đa số các web có sẵn nội dung) và áp dụng cho các ngôn ngữ khác. Điều này giúp chúng tôi trả kết quả có liên quan tốt hơn bằng nhiều ngôn ngữ trong Tìm kiếm.

Đối với các đoạn trích nổi bật (featured snippets), chúng tôi sử dụng mô hình BERT để cải thiện các đoạn trích nổi bật ở 24 quốc gia có tính năng này và nhận thấy những cải tiến ngôn ngữ đáng kể ví dụ như tiếng Hàn, tiếng Hindi và tiếng Bồ Đào Nha.

Tìm kiếm không phải là một vấn đề đã được giải quyết xong

Dù bạn đang tìm kiếm gì hay bạn nói ngôn ngữ gì, chúng tôi hy vọng bạn có thể không dùng một số từ khóa bất kỳ và tìm kiếm theo cách tự nhiên. Nhưng thỉnh thoảng bạn vẫn gây trở ngại cho Google.

Ngay cả với BERT, chúng tôi không phải lúc nào cũng hiểu đúng. Nếu bạn tìm kiếm “what state is south of Nebraska”, BERT sẽ phỏng đoán là quận có tên “South Nebraska”. (Nếu bạn nghĩ đó không phải ở Kansas, bạn đã đúng.)

Hiểu ngôn ngữ luôn là một thách thức và đó là động lực giúp chúng tôi tiếp tục cải thiện Tìm kiếm.

Chúng tôi liên tục hoàn thiện hơn và làm việc để tìm ra ý nghĩa — và thông tin hữu ích nhất – những tìm kiếm của bạn.

Bài viết lược dịch nguồn từ blog.google. Trong quá trình tham khảo rất hi vọng được sự góp ý của bạn đọc.

Chúng tôi sẽ cố gắng dịch và chia sẻ nhiều bài viết về SEO trên TranNgocThuy.com vì vậy hãy thường xuyên ghé qua mỗi ngày.

Like fanpage Đào tạo SEO Manager Trần Ngọc Thùy để nhận bài viết mới nhất hoặc có thể điền form nhận bản tin phía dưới.